来源:小编 更新:2024-12-22 07:05:04

用手机看

在深度学习领域,模型融合(Ensemble)和简单相加(Adding)是两种常见的模型优化方法。它们各自具有独特的优势和适用场景,本文将深入探讨这两种方法的基本原理、应用场景以及优缺点。

Ensemble是一种通过组合多个模型来提高预测性能的技术。其核心思想是利用多个模型的预测结果,通过某种方式融合这些结果,从而得到一个更准确的预测。

Adding是一种简单的模型优化方法,它通过将多个模型的预测结果直接相加,得到最终的预测结果。这种方法通常用于线性模型,如线性回归和逻辑回归。

Ensemble方法主要包括以下几种类型:

Bagging:通过自助法(Bootstrap)从原始数据集中抽取多个训练集,分别训练多个模型,然后对它们的预测结果进行平均或投票。

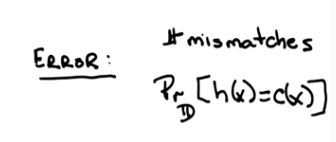

Boosting:通过迭代地训练多个模型,每个模型都针对前一个模型的预测错误进行优化,从而提高整体预测性能。

Stacking:将多个模型作为基模型,训练一个新的模型来融合这些基模型的预测结果。

Adding方法的基本原理非常简单,即将多个模型的预测结果直接相加。对于线性回归模型,可以将每个模型的预测结果相加,得到最终的预测值。对于分类模型,可以将每个模型的预测概率相加,然后通过阈值函数得到最终的预测类别。

Ensemble和Adding方法在深度学习中的应用场景如下:

Ensemble方法:

提高模型预测性能:通过组合多个模型的预测结果,可以降低模型的方差和偏差,提高预测精度。

处理高维数据:Ensemble方法可以有效地处理高维数据,提高模型的泛化能力。

提高模型鲁棒性:通过组合多个模型,可以提高模型对噪声和异常值的鲁棒性。

Adding方法:

简化模型:Adding方法可以简化模型结构,降低计算复杂度。

提高预测速度:由于Adding方法通常涉及简单的加法运算,因此可以提高预测速度。

适用于线性模型:Adding方法适用于线性回归和逻辑回归等线性模型。

Ensemble和Adding方法各有优缺点,具体如下:

Ensemble方法:

优点:

提高预测性能

处理高维数据

提高模型鲁棒性

缺点:

计算复杂度高

需要大量训练数据

模型融合难度大

Adding方法:

优点:

简化模型结构

提高预测速度

适用于线性模型

缺点:

预测性能有限

<